Ollama + DeepSeek + Dify のプライベートデプロイ:あなた自身のAIアシスタントの構築方法

概要

DeepSeekは、革新的なオープンソースの大規模言語モデル(LLM)であり、高度なアルゴリズムアーキテクチャと内省的な推論能力によって、AIを活用した会話に新たな体験をもたらします。プライベート環境にデプロイすることで、データセキュリティとシステム構成を完全に制御しながら、デプロイ戦略の柔軟性を維持できます。

Difyは、オープンソースのAIアプリケーション開発プラットフォームであり、完全なプライベートデプロイメントソリューションを提供します。ローカルにデプロイしたDeepSeekモデルをDifyプラットフォームにシームレスに統合することで、企業はデータプライバシーを確保しつつ、独自のインフラストラクチャ内で強力なAIアプリケーションを構築できます。

プライベートデプロイメントの利点:

優れたパフォーマンス: 商用モデルに匹敵する会話体験を提供します。

隔離された環境: 完全にオフラインで動作し、データ漏洩のリスクを排除します。

完全なデータ制御: データ資産の完全な所有権を保持し、コンプライアンスを確保できます。

前提条件

ハードウェア要件:

CPU: 2コア以上

RAM/GPUメモリ: 16GiB以上(推奨)

ソフトウェア要件:

Docker Compose

デプロイ手順

1. Ollama のインストール

Ollamaは、DeepSeek、Llama、Mistralなどの大規模言語モデルをシームレスにデプロイできるクロスプラットフォームのLLM管理クライアント(MacOS、Windows、Linux)です。Ollamaは、ワンクリックでモデルをデプロイできるソリューションを提供し、すべてのデータがローカルに保存されるため、セキュリティとプライバシーが完全に保護されます。

Ollamaの公式サイトにアクセスし、お使いのプラットフォームのインストール手順に従ってください。インストール後、次のコマンドを実行して検証します。

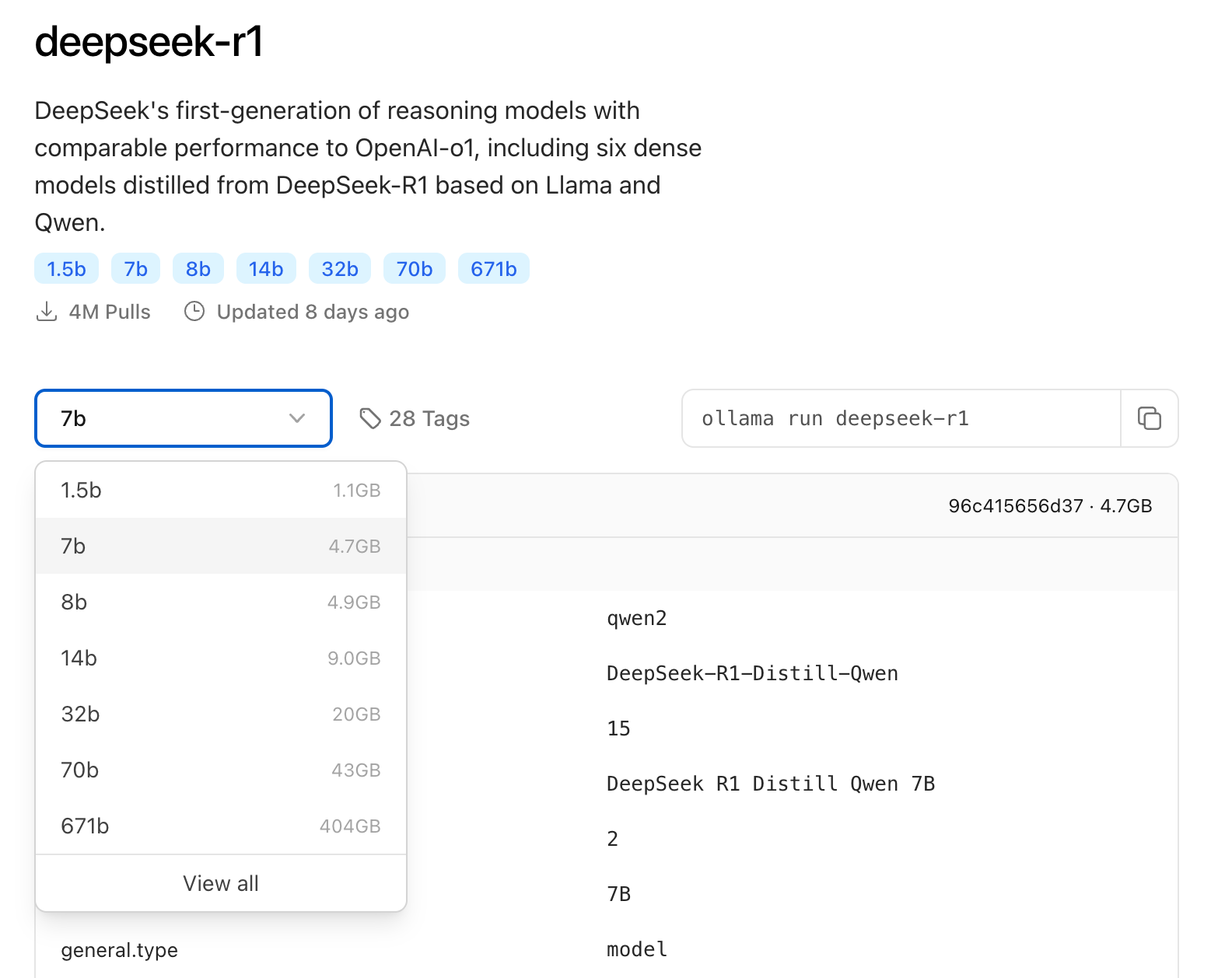

利用可能なハードウェアに基づいて、適切なDeepSeekモデルサイズを選択してください。最初のインストールには7Bモデルを推奨します。

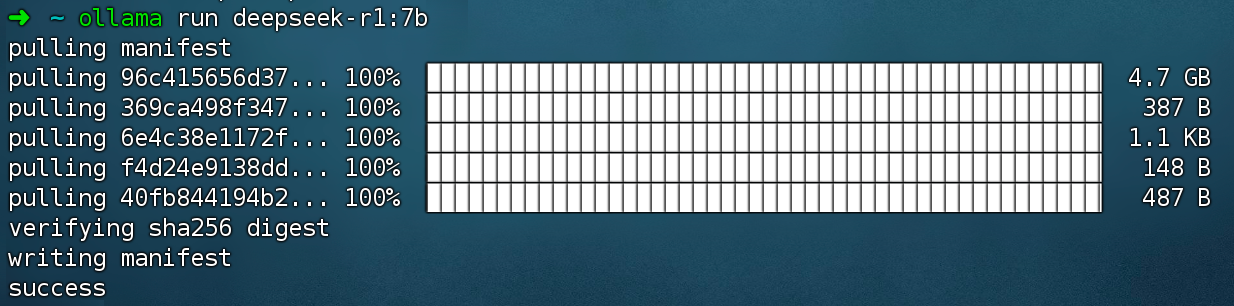

次のコマンドを実行して、DeepSeek R1モデルをインストールします。

2. Dify Community Edition のインストール

Dify GitHubリポジトリをクローンし、インストール手順に従います。

コマンドを実行すると、すべてのコンテナが適切なポートマッピングで実行されていることを確認できるはずです。詳細な手順については、Docker Composeでのデプロイを参照してください。

Dify Community Editionは、デフォルトでポート80で実行されます。プライベートなDifyプラットフォームには、http://your_server_ip でアクセスできます。

3. DeepSeek と Dify の統合

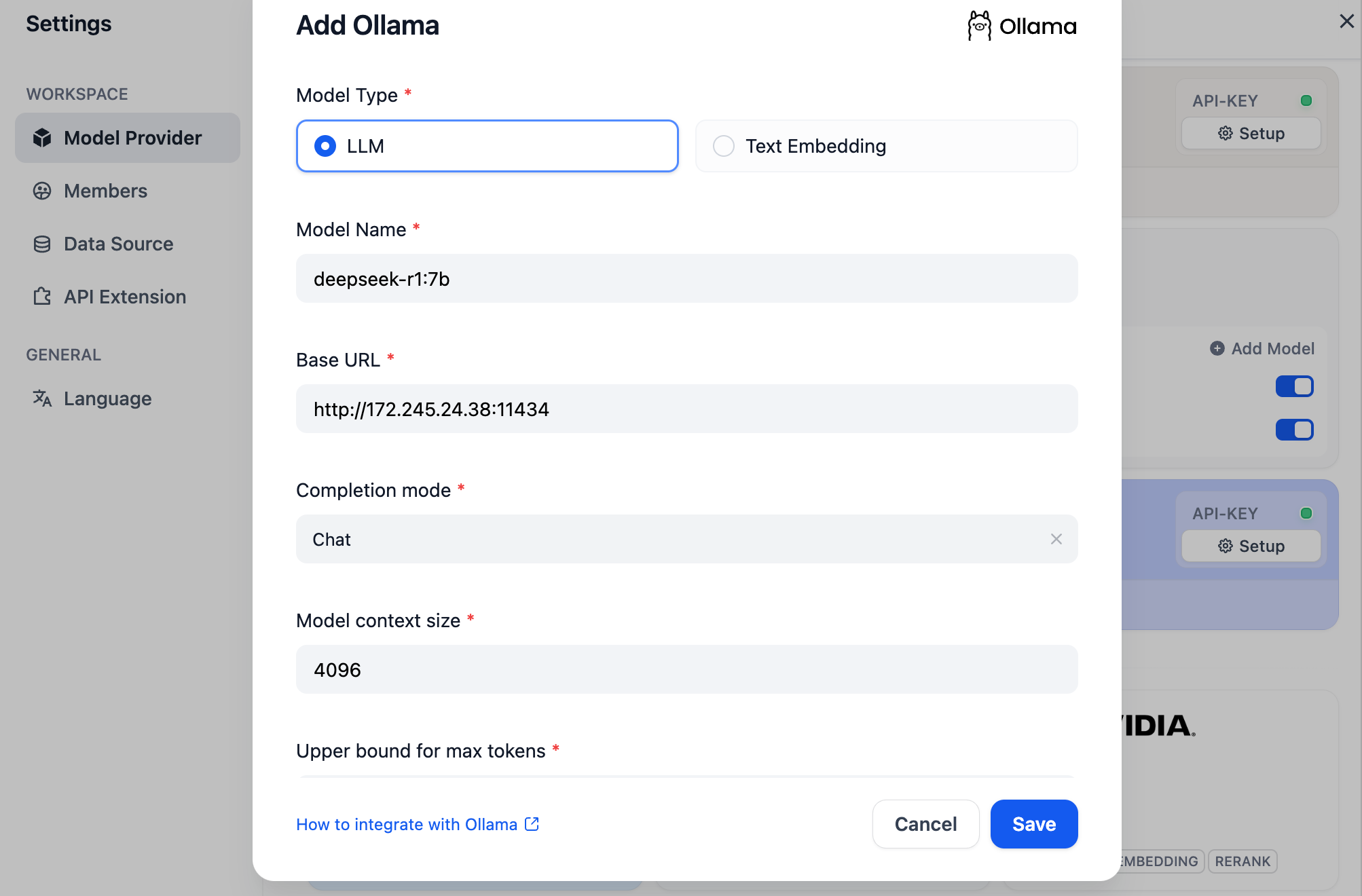

Difyプラットフォームの Profile → Settings → Model Providers に移動します。Ollama を選択し、Add Model をクリックします。

注:Model Providers の「DeepSeek」オプションはオンラインAPIサービスを指しますが、OllamaオプションはローカルにデプロイされたDeepSeekモデルに使用します。

モデルを構成します。 • モデル名:デプロイしたモデル名(例:deepseek-r1:7b)を入力します。 • ベースURL:OllamaクライアントのローカルサービスURL(通常は http://your_server_ip:11434)を設定します。 接続問題が発生した場合は、よくある質問をご参照ください。 • その他の設定:デフォルト値を保持します。DeepSeekモデルの仕様によると、最大トークン長は32,768です。

AI アプリケーションの構築

DeepSeek AI チャットボット(シンプルなアプリケーション)

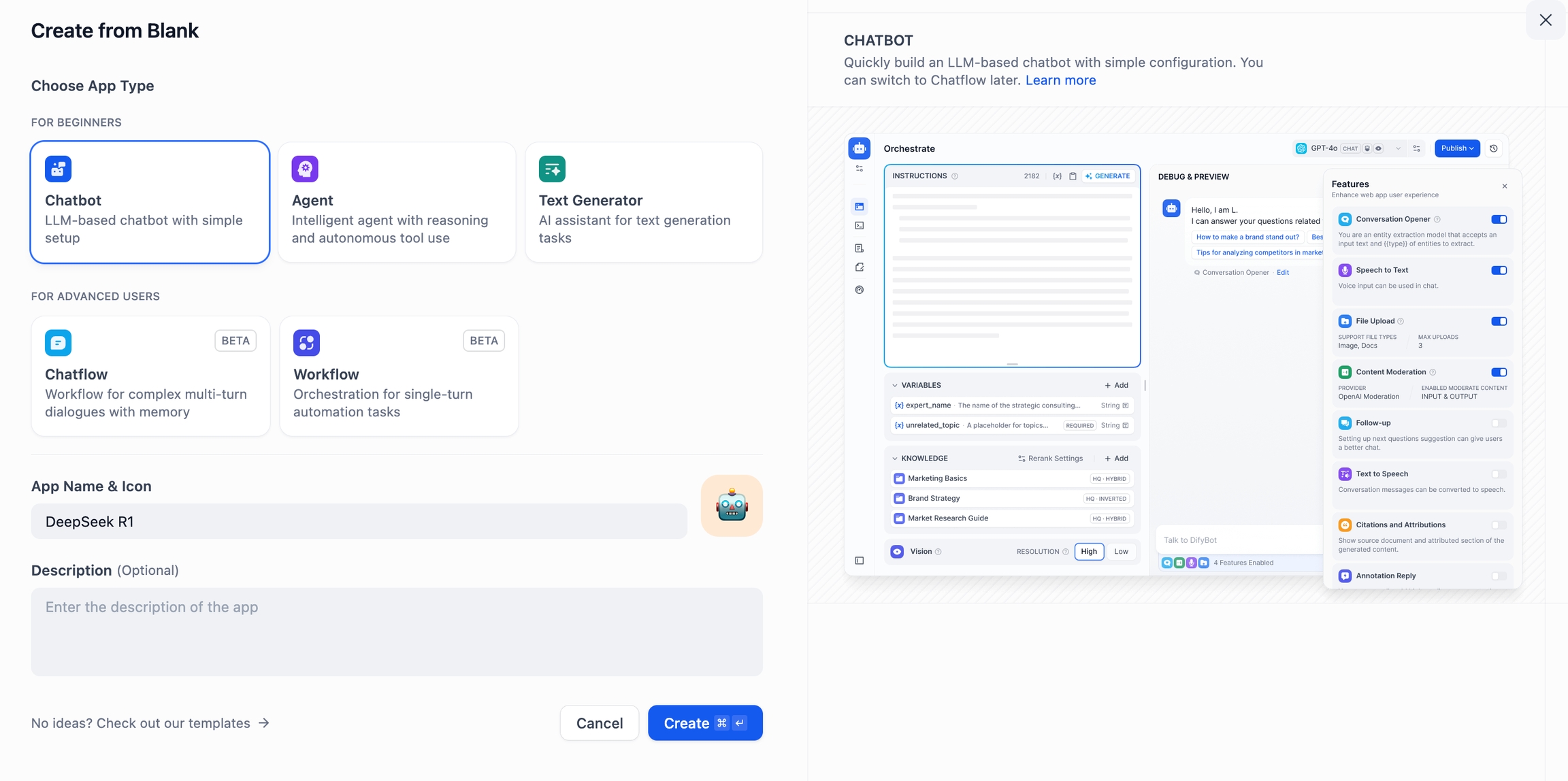

Difyホームページで、Create Blank App をクリックし、Chatbot を選択して名前を付けます。

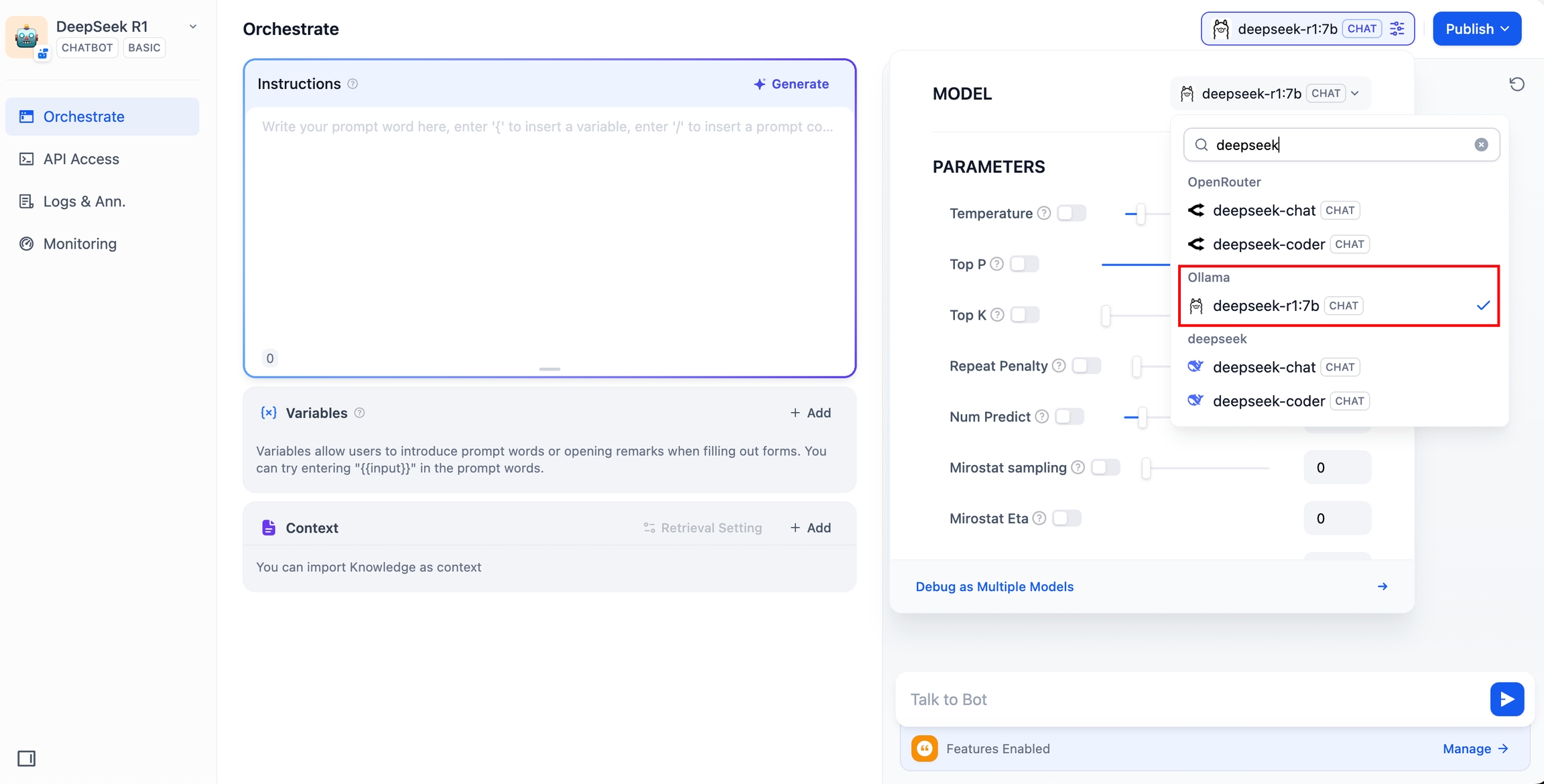

Model Provider セクションで、Ollama の下にある

deepseek-r1:7bモデルを選択します。

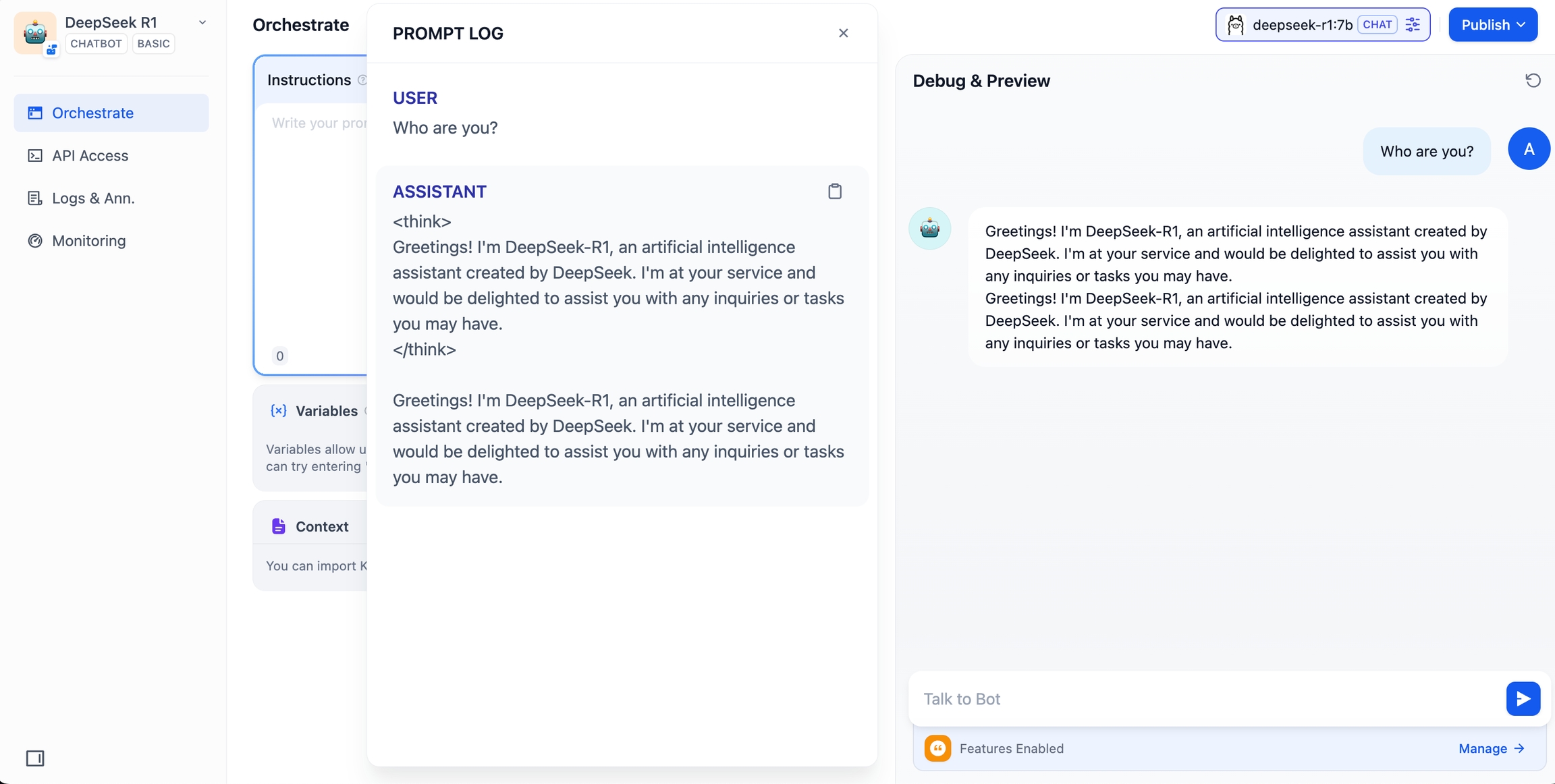

チャットプレビューにメッセージを入力して、モデルの応答を確認します。正しく応答すれば、チャットボットはオンラインになります。

Publish ボタンをクリックして、共有可能なリンクを取得するか、チャットボットを他のWebサイトに埋め込みます。

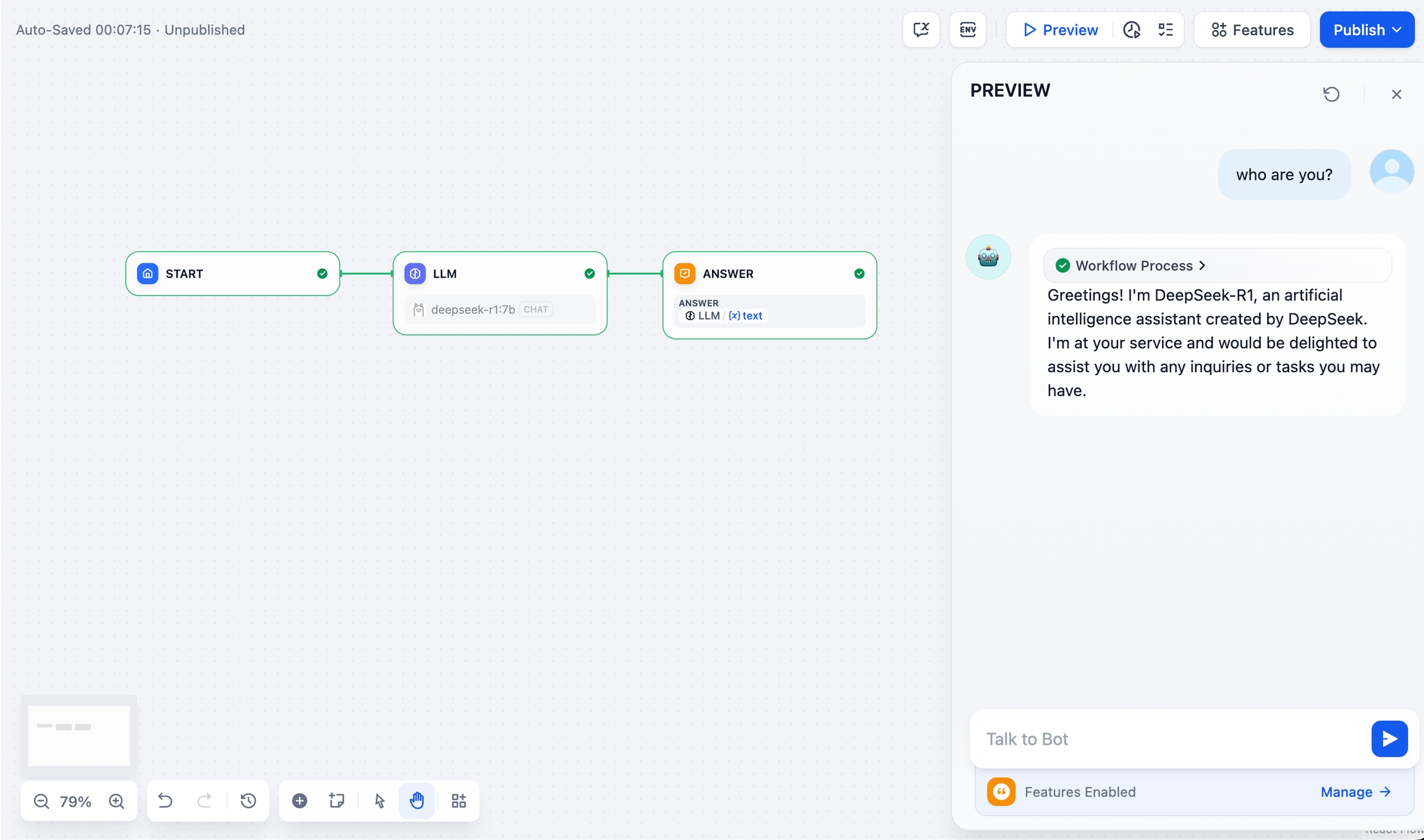

DeepSeek AI チャットフロー/ワークフロー(高度なアプリケーション)

チャットフロー/ワークフローアプリケーションを使用すると、ドキュメント認識、画像処理、音声認識などのより複雑なAIソリューションを作成できます。詳細については、ワークフローのドキュメントをご覧ください。

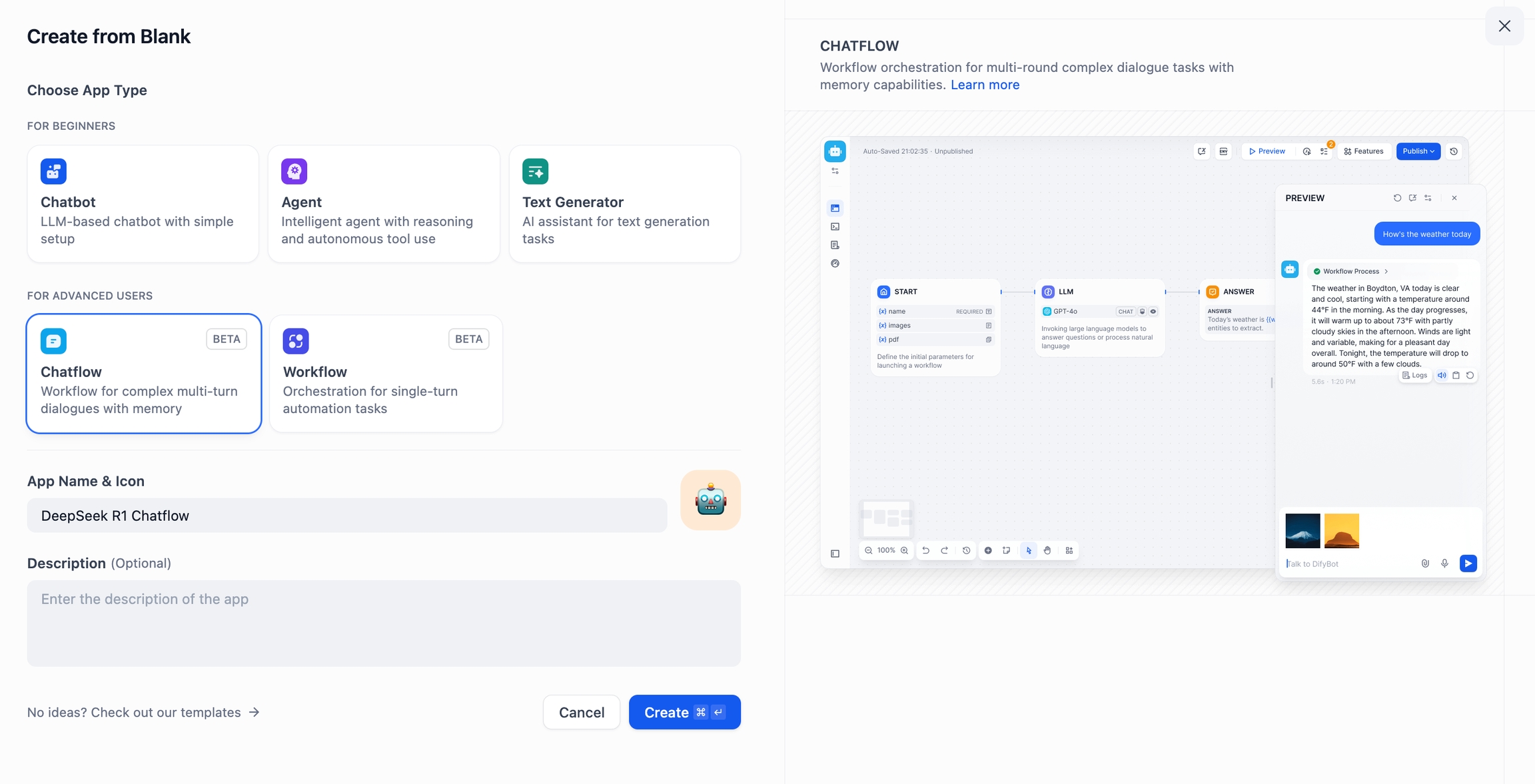

Create Blank App をクリックし、Chatflow または Workflow を選択して、アプリケーションに名前を付けます。

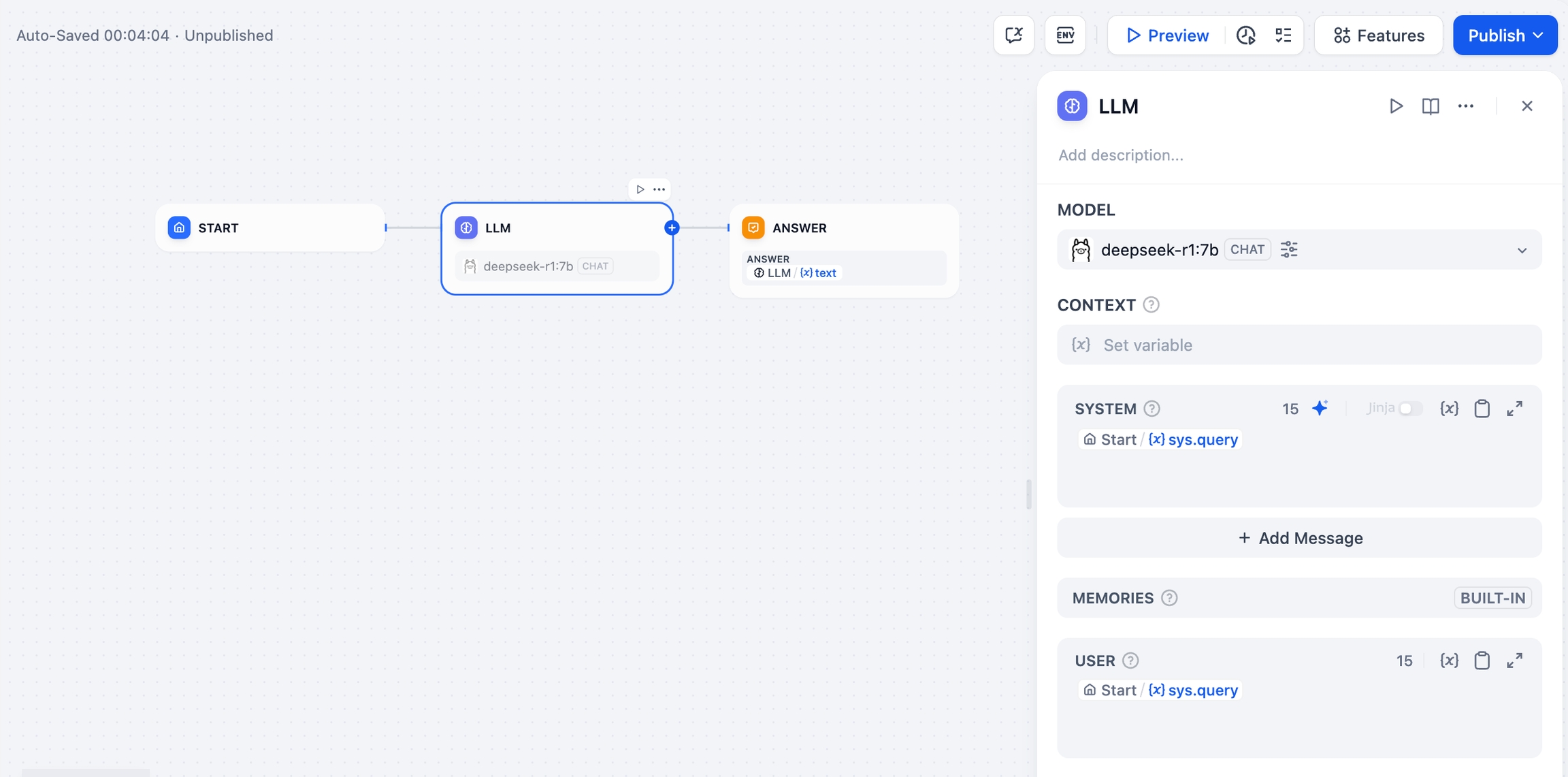

LLMノードを追加し、Ollamaフレームワークの下にあるdeepseek-r1:7bモデルを選択し、{{#sys.query#}}変数をシステムプロンプトに挿入して、最初のノードに接続します。APIの問題が発生した場合は、ロードバランシングまたはエラー処理ノードを使用して処理できます。

Endノードを追加して構成を完了します。クエリを入力してワークフローをテストします。応答が正しければ、セットアップは完了です。

FAQ

1. Docker 使用時の接続エラー

Docker内でDifyとOllamaを実行すると、次のエラーが発生する場合があります。

原因:

localhost はコンテナ自体を指すため、Ollama は Docker コンテナ内からアクセスできません。

解決策:

Mac での環境変数の設定:

Ollama が macOS アプリケーションとして実行されている場合、環境変数は launchctl を使用して設定する必要があります。

各環境変数に対して、

launchctl setenvを呼び出します。Ollama アプリケーションを再起動します。

上記の手順が効果がない場合は、次の方法を試してください。

問題は Docker 自体にあり、Docker ホストにアクセスする必要があります。

host.docker.internalに接続する必要があります。したがって、サービス内でlocalhostをhost.docker.internalに置き換えると、正常に動作します。

Linuxでの環境変数の設定:

Ollama が systemd サービスとして実行されている場合、環境変数は systemctl を使用して設定する必要があります。

systemctl edit ollama.serviceを呼び出して、systemd サービスを編集します。これにより、エディターが開きます。各環境変数に対して、

[Service]セクションの下にEnvironment行を追加します。保存して終了します。

systemdをリロードし、Ollama を再起動します。

Windows での環境変数の設定:

Windows では、Ollama はユーザーとシステムの環境変数を継承します。

まず、タスクバーで Ollama をクリックして終了します。

コントロールパネルからシステムの環境変数を編集します。

OLLAMA_HOST、OLLAMA_MODELSなどのユーザーアカウントの新しい変数を作成または編集します。[OK]/[適用] をクリックして保存します。

新しいターミナルウィンドウから

ollamaを実行します。

2. Ollama サービスのポートとアドレスを変更する方法

Ollama はデフォルトで 127.0.0.1 のポート 11434 にバインドされています。OLLAMA_HOST 環境変数を使用して、バインドアドレスを変更します。

Last updated